-

-

바닥부터 배우는 강화 학습

노승은 지음 / 영진.com(영진닷컴) / 2020년 9월

평점 :

지난 2016년 3월 이세돌 기사와 알파고와의 한판 승부는 세상을 깜짝 놀라게 했다. 바둑에서 나올 수 있는 경우의 수는 무려 10의 170승이라고 알려져 있다. AI가 아무리 뛰어나더라도 과연 인간의 두뇌를 따라올 수 있으려나 했다. 그렇지만 이세돌, 아니 인간은 무릎을 꿇었다. AI를 통한 딥 러닝이 이 정도로 발전했구나 싶었다.

이 책은 딥 러닝과 핵심이 되는 강화 학습을 초보자도 알기 쉽게 설명한다. 강화 학습에 가장 기본이 되는 개념부터 실무 사례까지 한 권으로 정리했다.

저자 노승은 씨는 서울대에서 컴퓨터공학과 경제학을 전공하고, 현재 엔씨소프트 GameAI랩에서 강화 학습을 연구하고 있다. 강화 학습 유튜브 채널 ‘팡요랩’도 운영 중이다. 그는 머리말에서 이 책을 집필하면서 특히 두 가지를 염두에 두었다고 밝힌다. 첫 번째는 ‘쉽게’, 두 번째는 ‘기본에 충실하게’다.

책은 강화 학습의 뼈대가 되는 MDP부터 딥 러닝과 강화 학습이 만나는 지점 및 학습 방법론, 알파고, 알파고 제로까지 기초부터 응용까지 포괄적으로 다룬다. 실제 사례로 저자가 몸 담은 엔씨소프트 GameAI랩에서 개발한 ‘블레이드&소울 비무’를 통해 강화 학습을 어떻게 적용하는지 노하우를 배울 수 있다.

책은 다음과 같이 모두 11장으로 구성돼 있다.

1. 강화 학습이란

2. 마르코프 결정 프로세스

3. 벨만 방정식

4. MDP를 알 때의 플래닝

5. MDP를 모를 때 밸류 평가하기

6. MDP를 모를 때 최고의 정책 찾기

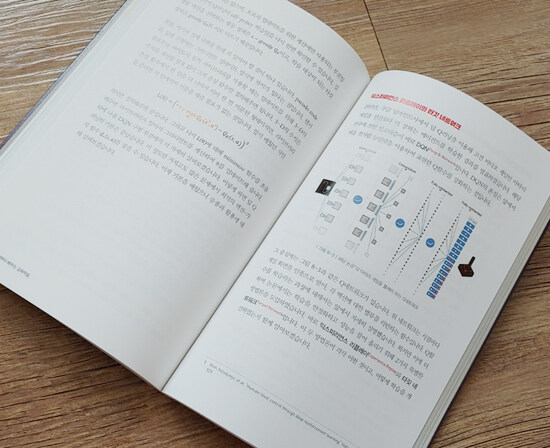

7. Deep RL 첫걸음

8. 가치 기반 에이전트

9. 정책 기반 에이전트

10. 알파고와 MCTS

11. 블레이드&소울 비무 AI 만들기

먼저 강화 학습이 무엇인지 설명한다. 지도 학습이 지도자가 가르쳐 주거나 정답이 있는 상태에서 배우는 것인 반면, 강화 학습은 스스로 시행착오를 통해 배우는 것이다. 이때 중요한 개념은 전이 확률과 보상 함수다.

전이 확률이란 ‘현재 상태가 s이며 에이전트가 액션 a를 선택했을 때 다음 상태가 s′이 될 확률’을 말한다. 표기는 다음과 같다.

보상 함수는 어떤 상태 s에 도달했을 때 받게 되는 보상을 의미한다. 전이 확률과 보상 함수는 값이 조금씩 다르게 나올 수 있기 때문에 기대치로 표시된다.

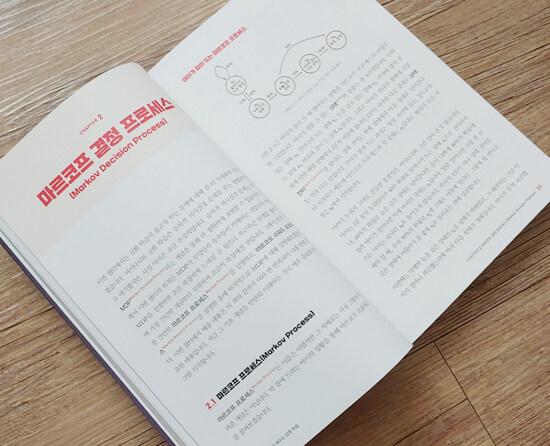

다음은 MP, MRP와 MDP에 대해 살펴본다. MP는 마르코프 프로세스(Markov Decision Process)를 말하여 ‘가능한 상태를 모두 모아놓은 집합’을 뜻한다. MP에 보상의 개념이 추가되면 MRP (Markov Reward Process)가 되고, MRP에 에이전트가 더해지면 MDP (Markov Decision Process)가 된다.

MDP는 의사결정 과정을 모델링하는 틀을 제공한다. MDP의 구성 요소는 S, A, P, R, γ 등 5가지다. 여기서 S는 상태의 집합, A는 액션의 집합, P는 전이 확률 행렬, R은 보상 함수, γ는 감쇠 인자를 뜻한다.

저자는 일반 독자들이 강화 학습을 이해하기 위해 필요한 개념과 용어를 알기 쉽게 다룬 다음, 알파고를 위해하기 위한 MCTS를 설명한다. MCTS (Monte Carlo Tree Search)는 주어진 상황에서 시작하여 “그냥 많이 둬 보는” 방법론을 말한다. 바둑에 최적화된 기법이 아닐 수 없다.

이제 마지막 단계다. 저자가 참여한 ‘블레이드&소울 비무’ 게임에서 어떻게 강화학습이 적용됐는지 엿볼 수 있다.

나는 이 책으로 AI의 핵심 기술이라고 할 수 있는 딥 러닝과 강화 학습이 어떤 프로세스로 작동되는지 차근차근 배울 수 있었다. 자동 로봇을 활용한 코딩에 관심이 많은 중학생 아들도 즐겁게 읽을 수 있었다. 강화 학습과 관련된 개념과 기법을 초보자도 알기 쉽게 풀어준 저자의 열정에 박수를 보내드린다.